Специалисты Yandex Research совместно с исследователями ISTA и KAUST разработали и представили новые методы сжатия больших языковых моделей. С их помощью представители бизнеса смогут сократить расходы на вычислительные ресурсы до восьми раз. По заявлению в блоге Яндекса, решение будет полезно для корпораций, стартапов или исследователей, использующих нейросети на своем оборудовании.

Для корректной работы больших языковых моделей требуются дорогостоящие и мощные графические процессоры. Для исключения напрасного использования больших мощностей решение Яндекса позволяет уменьшать модели, применять для этого менее мощные процессоры и запускать их на устройствах с меньшей вычислительной мощностью.

Для разработки компании применяется два инструмента. Первый позволяет уменьшать до восьми раз нейросеть, которая быстрее работает и может быть запущена, например, на одном графическом процессоре вместо четырех. Второй инструмент исправляет ошибки, возникающие в процессе сжатия большой языковой модели.

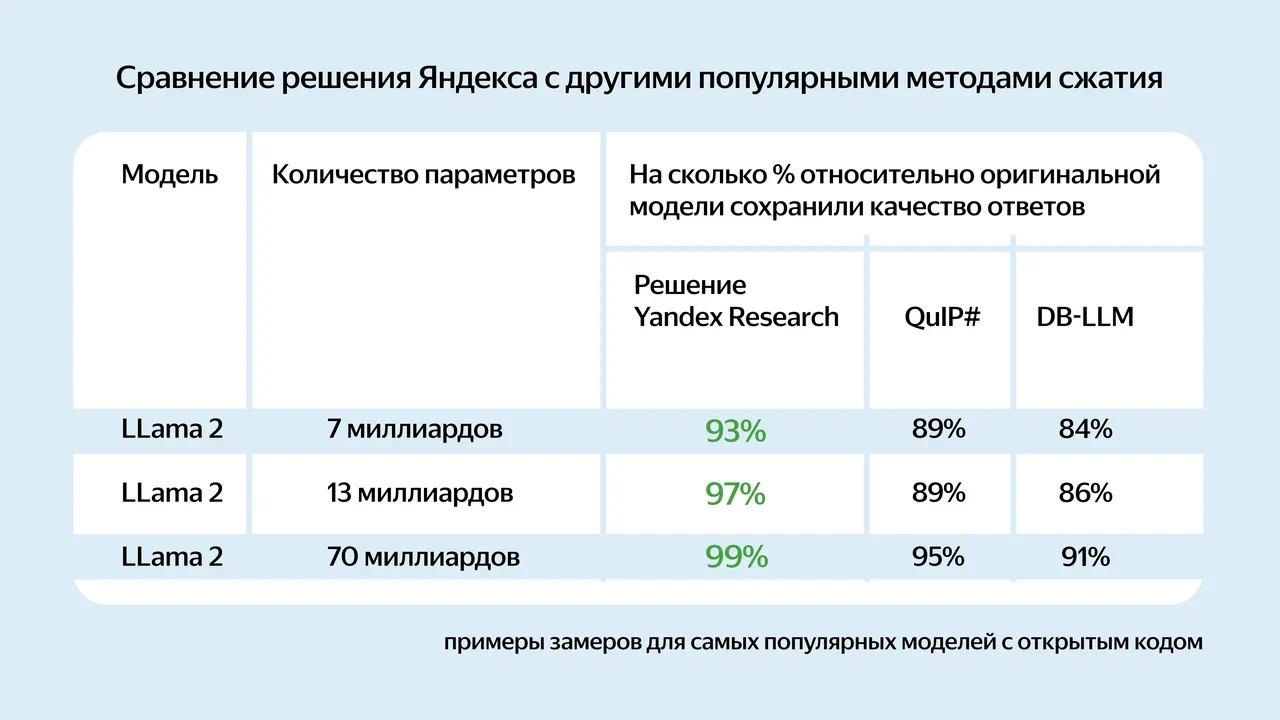

Эффективность сжатия нейросетей оценивалась на популярных моделях с открытым исходным кодом, таких как Llama 2, Llama 3, Mistral и так далее. Качество ответов оригинальной и сжатой версии нейросети сравнивали на англоязычных тестах, состоящих из наборов вопросов для оценки разных областей знаний. Новый подход показал лучший результат среди всех существующих методов сжатия. Метод Яндекса сохраняет в среднем 95% качества ответов нейросети. Для сравнения, другие популярные инструменты сохраняют для тех же моделей от 59% до 90% качества.

Источник: блог Яндекса (здесь и на обложке)

Новые методы сжатия нейросетей уже доступны для применения, а код был опубликован на GitHub. Для скачивания также доступны уже сжатые с помощью новых методов популярные модели с открытым исходным кодом. Кроме того, исследователи Yandex Research выложили обучающие материалы для помощи разработчикам в дополнительном обучении уменьшенных нейросетей под свои сценарии.

Комментарии