Моя лента

Новое

Популярное

232

Где хранятся и как найти временные файлы Word

Временные файлы Word создаются автоматически во время работы с документами и служат для защиты данных от потери при сбоях, управления памятью и обеспечения корректной работы функций буфера обмена.

162

Как зарабатывать 200 тысяч рублей на курсе для дизайнеров еще на этапе подготовки

Всем привет! Меня зовут Даниил Клинчук, я дизайнер и автор блога «клинчук, такнепойдет». У меня есть небольшая студия разработки сайтов, где я выступаю в роли арт-директора: контролирую конечный результат и помогаю его улучшить.

158

Как понять, что бизнесу пора запускать сайт

Многие владельцы бизнеса долго откладывают решение о запуске сайта. Они думают, что и без него все идет хорошо. Это естественное стремление не торопиться и заниматься другими важными задачами. Например, привлечением клиентов и улучшением продукта. Но если вы еще не начали развивать свой сайт, есть риск, что конкуренты вас уже опередили. Так когда же пора переходить в онлайн?

210

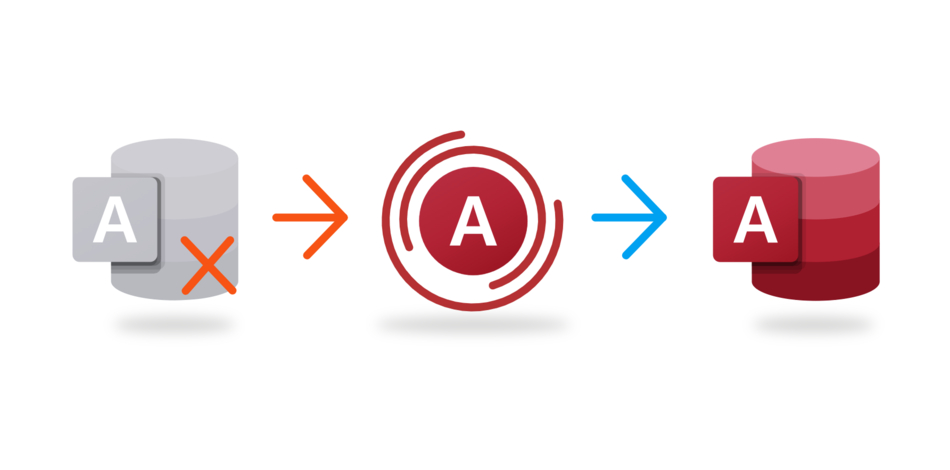

Три способа спасти офис, вылечив базу данных Microsoft Access

Если в организации корпоративные данные хранятся в Microsoft Access, скорее всего, речь о небольшой организации. И вот база Access внезапно перестаёт открываться, а сисадмин будет нескоро. Отличный шанс проявить себя и «вытащить» всю команду – я проходил через такое и собрал рабочие варианты.

483

IP-камера Яндекса научилась описывать события, происходящие в кадре

Яндекс обновил умную IP-камеру – благодаря искусственному интеллекту устройство научилось понимать, какие конкретно события происходят в кадре. Вместо обезличенных сообщений, что было обнаружено движение, пользователь получает точные уведомления – например, что дети пришли из школы или в комнату зашла собака.

Вакансии в Timeweb

PHP Developer (middle)

🏰 Санкт-Петербург 💷 Зарплата: от 150 000 руб. на руки 💪 Опыт: 3-6 лет 💼 Полная занятость, можно удаленно

Python Developer

🏰 Санкт-Петербург 💷 Зарплата: обсуждается 💪 Опыт: 3-6 лет 💼 Полная занятость, гибридный формат работы

Product Owner / Менеджер продукта MyReviews

🏰 Санкт-Петербург 💷 Зарплата: обсуждается 💪 Опыт: 1-3 года 💼 Полная занятость, гибридный формат работы

Lead / Senior JavaScript developer

🏰 Санкт-Петербург 💷 Зарплата: обсуждается 💪 Опыт: 3-6 лет 💼 Полная занятость